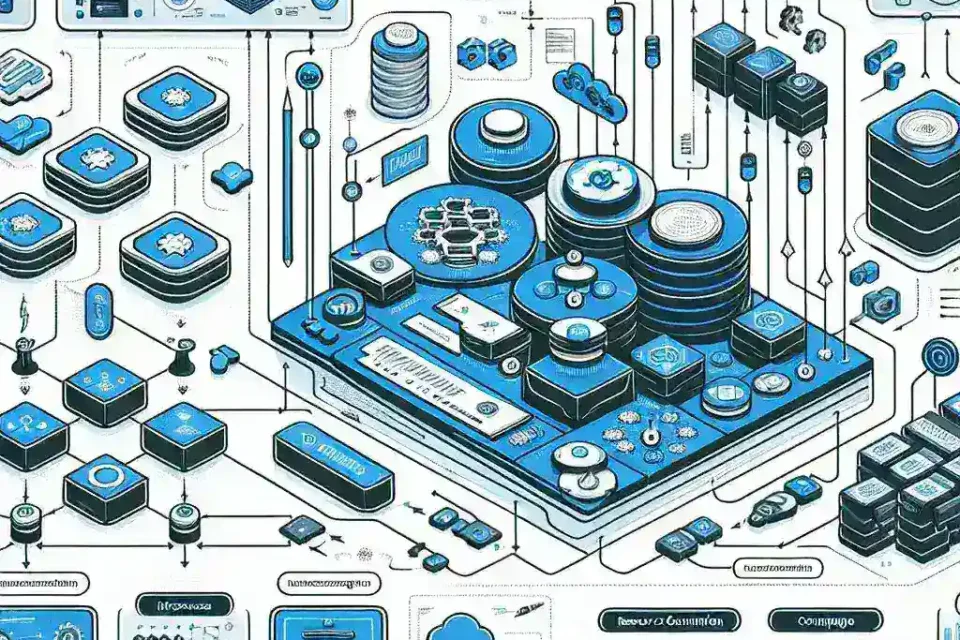

Herramientas para análisis del consumo de recursos por microservicio: Guía completa 2024

La arquitectura de microservicios ha revolucionado el desarrollo de aplicaciones modernas, permitiendo mayor escalabilidad, flexibilidad y mantenibilidad. Sin embargo, esta fragmentación también introduce nuevos desafíos en el monitoreo y análisis del consumo de recursos. En un ecosistema donde múltiples servicios independientes interactúan constantemente, comprender cómo cada componente utiliza los recursos del sistema se vuelve fundamental para mantener un rendimiento óptimo.

¿Por qué es crucial el análisis de recursos en microservicios?

En una arquitectura monolítica tradicional, el monitoreo de recursos era relativamente sencillo: una aplicación, un servidor, métricas centralizadas. Con microservicios, este panorama cambia drásticamente. Cada servicio puede tener patrones de consumo únicos, ejecutarse en diferentes contenedores o máquinas virtuales, y escalar independientemente según la demanda.

El análisis detallado del consumo de recursos permite a los equipos de desarrollo y operaciones identificar cuellos de botella, optimizar costos, prevenir fallos y tomar decisiones informadas sobre escalado horizontal o vertical. Además, facilita la implementación de políticas de auto-escalado más precisas y la detección temprana de anomalías en el comportamiento de los servicios.

Métricas fundamentales a monitorear

Antes de explorar las herramientas disponibles, es esencial comprender qué métricas son críticas para el análisis de recursos en microservicios:

- CPU: Utilización del procesador, tiempo de respuesta y frecuencia de uso

- Memoria: Consumo RAM, memory leaks y garbage collection

- Red: Latencia, throughput y errores de conectividad

- Almacenamiento: I/O de disco, espacio utilizado y velocidad de acceso

- Contenedores: Estado de pods, réplicas y distribución de carga

Herramientas líderes para monitoreo de microservicios

Prometheus y Grafana

Esta combinación representa uno de los estándares de facto en el ecosistema de monitoreo de microservicios. Prometheus actúa como el motor de recolección de métricas, utilizando un modelo pull-based que consulta endpoints HTTP de los servicios para obtener datos en tiempo real.

Las ventajas de Prometheus incluyen su arquitectura distribuida, capacidad de almacenamiento de series temporales y potente lenguaje de consultas PromQL. Se integra perfectamente con Kubernetes y proporciona alertas configurables basadas en umbrales personalizados.

Por su parte, Grafana complementa a Prometheus ofreciendo dashboards visuales altamente personalizables. Permite crear gráficos interactivos, paneles de control en tiempo real y reportes automatizados que facilitan la interpretación de datos complejos.

Datadog

Como solución SaaS integral, Datadog ofrece monitoreo unificado para infraestructura, aplicaciones y logs. Su fortaleza radica en la correlación automática entre métricas de diferentes capas del stack tecnológico, proporcionando una visión holística del rendimiento del sistema.

La plataforma incluye funcionalidades avanzadas como distributed tracing, que permite seguir una solicitud a través de múltiples microservicios, identificando exactamente dónde ocurren los cuellos de botella. Su sistema de alertas inteligentes utiliza machine learning para detectar anomalías y reducir falsos positivos.

New Relic

New Relic se posiciona como una plataforma de observabilidad completa que combina monitoreo de aplicaciones (APM), infraestructura y experiencia del usuario final. Su agente de monitoreo se integra directamente en el código de aplicación, proporcionando insights detallados sobre el rendimiento de cada microservicio.

Una característica distintiva es su capacidad de análisis de dependencias, que mapea automáticamente las relaciones entre servicios y visualiza el flujo de datos. Esto resulta invaluable para comprender el impacto en cascada de problemas de rendimiento.

Elastic Stack (ELK)

La combinación de Elasticsearch, Logstash y Kibana proporciona una solución robusta para agregación, búsqueda y visualización de logs y métricas. Elasticsearch actúa como motor de búsqueda y analytics, mientras que Logstash se encarga de la ingesta y procesamiento de datos.

Kibana ofrece interfaces de visualización que permiten crear dashboards personalizados y realizar análisis exploratorios de datos. La adición de Beats (agentes ligeros de recolección) completa el ecosistema, facilitando la captura de métricas desde diferentes fuentes.

Jaeger

Especializado en distributed tracing, Jaeger se ha convertido en una herramienta esencial para el análisis de rendimiento en arquitecturas de microservicios complejas. Permite rastrear solicitudes individuales a medida que atraviesan múltiples servicios, identificando latencias y errores en cada hop.

Su integración con OpenTracing estándar facilita la instrumentación de aplicaciones, mientras que su interfaz web intuitiva permite analizar traces de manera visual, identificando patrones de comportamiento y optimizando rutas críticas.

Herramientas especializadas por casos de uso

Para entornos Kubernetes

Kubernetes Dashboard proporciona una vista nativa del estado del cluster, incluyendo métricas básicas de pods y nodos. cAdvisor se integra directamente con kubelet para monitorear contenedores, ofreciendo métricas detalladas de consumo de recursos a nivel de contenedor.

Kube-state-metrics expone métricas del estado del cluster en formato Prometheus, facilitando la integración con pipelines de monitoreo existentes.

Para análisis de costos

Kubecost se especializa en proporcionar visibilidad financiera sobre el consumo de recursos en Kubernetes. Calcula costos por namespace, aplicación o equipo, facilitando la optimización presupuestaria y la asignación de recursos.

Para monitoreo sintético

Pingdom y UptimeRobot ofrecen monitoreo externo de disponibilidad y rendimiento, simulando interacciones de usuarios reales con los microservicios desde múltiples ubicaciones geográficas.

Implementación de estrategias de monitoreo

La implementación exitosa de herramientas de análisis requiere una estrategia bien definida que considere los siguientes aspectos:

Instrumentación del código

La instrumentación proactiva del código fuente es fundamental para obtener métricas precisas. Esto incluye la adición de contadores, temporizadores y gauges en puntos críticos de la aplicación, utilizando librerías como Micrometer para Java o Prometheus client libraries para otros lenguajes.

Definición de SLIs y SLOs

Establecer Service Level Indicators (SLIs) y Service Level Objectives (SLOs) proporciona un marco objetivo para evaluar el rendimiento. Los SLIs típicos incluyen latencia de respuesta, tasa de errores y disponibilidad, mientras que los SLOs definen los umbrales aceptables para estos indicadores.

Alertas inteligentes

Configurar alertas efectivas requiere equilibrar sensibilidad y especificidad para evitar tanto la fatiga de alertas como la pérdida de incidentes críticos. Implementar alertas basadas en tendencias y anomalías, en lugar de umbrales estáticos, mejora significativamente la precisión.

Desafíos comunes y soluciones

Correlación de datos distribuidos

Uno de los principales desafíos en el monitoreo de microservicios es correlacionar eventos y métricas across servicios distribuidos. La implementación de trace IDs únicos que se propagan a través de todas las llamadas de servicio facilita esta correlación.

Overhead de monitoreo

El monitoreo excesivo puede impactar negativamente el rendimiento de los microservicios. Es crucial encontrar el equilibrio entre observabilidad completa y overhead mínimo, implementando sampling inteligente y optimizando la frecuencia de recolección de métricas.

Gestión de volumen de datos

Los microservicios pueden generar volúmenes masivos de datos de telemetría. Implementar estrategias de retención inteligente, agregación de métricas y archivado automático ayuda a controlar costos de almacenamiento sin perder información crítica.

Tendencias futuras en monitoreo de microservicios

El campo del monitoreo de microservicios continúa evolucionando rápidamente. La adopción de eBPF está revolucionando la observabilidad a nivel de kernel, proporcionando insights sin modificar el código de aplicación. El service mesh, liderado por tecnologías como Istio y Linkerd, está integrando capacidades de observabilidad directamente en la infraestructura de red.

La inteligencia artificial y el machine learning están transformando la detección de anomalías y la predicción de problemas, mientras que la observabilidad como código está automatizando la configuración y mantenimiento de pipelines de monitoreo.

Conclusión

El análisis efectivo del consumo de recursos en microservicios requiere una combinación cuidadosa de herramientas, estrategias y mejores prácticas. Desde soluciones open-source como Prometheus y Grafana hasta plataformas comerciales como Datadog y New Relic, cada opción ofrece ventajas específicas según el contexto y requisitos organizacionales.

El éxito en la implementación depende no solo de la selección de herramientas adecuadas, sino también de una instrumentación thoughtful, definición clara de objetivos de rendimiento y configuración inteligente de alertas. A medida que las arquitecturas de microservicios continúan evolucionando, las herramientas de monitoreo deben adaptarse para proporcionar la visibilidad necesaria para mantener sistemas resilientes y eficientes.

La inversión en herramientas robustas de análisis de recursos no solo mejora la confiabilidad operacional, sino que también facilita la optimización continua, reduce costos y acelera la resolución de problemas. En un panorama donde la complejidad de los sistemas distribuidos continúa creciendo, estas herramientas se vuelven indispensables para el éxito de cualquier implementación de microservicios a escala empresarial.